Kafka-Nachrichten ausführen

Der Tricentis Tosca API Scan ermöglicht es Ihnen, Nachrichten über eine Apache-Kafka-Verbindung auszuführen. Ein Kafka-Thema speichert Datensätze, d. h. Nachrichten, die von einem oder mehreren Publishern gesendet und von einem oder mehreren Consumern gelesen werden. Dadurch können verschiedene Systeme unabhängig voneinander kommunizieren, z. B. wenn eines von ihnen offline ist. Darüber hinaus können Kafka-Themen in mehrere Partitionen unterteilt werden. Dies ermöglicht die Verteilung großer Datenmengen auf einen oder mehrere Server.

Die Producer sind für die Veröffentlichung von Datensätzen in einem Thema verantwortlich. Die Consumer lesen diese Datensätze. Jeder Consumer ist Teil einer Consumer-Gruppe, die ein Thema abonniert. Sie können wählen, ob Sie Datensätze veröffentlichen oder lesen möchten, d. h., ob Sie Nachrichten aus einem Kafka-Thema per Pull abrufen oder Nachrichten in ein Kafka-Thema per Push verschieben möchten.

Nachdem Sie Ihre Kafka-Datensätze im API Scan ausgeführt haben, können Sie sie in den Tosca Commander exportieren und anhand der Datensatzinformationen Modulattribute definieren und deren Werte überprüfen.

|

Kafka-Datensätze können nicht direkt aus dem API Scan zu OSV exportiert werden. Sie müssen sie zunächst in den Tosca Commander exportieren und die richtigen Aktionen manuell einstellen, bevor Sie sie in OSV hochladen. |

|

Die Authentifizierung mit der Kafka-Verbindung erfolgt über den SASL/PLAIN-Mechanismus. Die Kafka-Verbindung ist nur verfügbar, wenn die SASL/PLAIN-Authentifizierung aktiviert ist. |

Datensätze per Pull abrufen

Um Datensätze per Pull aus einem Kafka-Thema abzurufen, führen Sie die folgenden Schritte aus:

-

Erstellen Sie eine Nachricht aus einem URI oder einer Datei oder erstellen Sie eine neue Nachricht.

-

Wählen Sie eine Kafka-Verbindung aus dem Aufklappmenü Connection.

-

Wählen Sie Pull aus dem Aufklappmenü Action.

-

Sie können einen Partitions-Offset angeben, um Datensätze ab einer bestimmten Position per Pull abzurufen. Ein Offset definiert die Position eines Datensatzes in der Partition und hängt von der Reihenfolge ab, in der die Commits für die Datensätze durchgeführt wurden. Durch die Angabe eines Offsets können Sie festlegen, ob Sie z. B. mit dem Lesen älterer Datensätze beginnen möchten oder mit dem neuesten Datensatz. Standardmäßig ruft der API Scan den letzten ungelesenen Datensatz per Pull ab.

Um den Offset anzugeben, geben Sie eine Nummer in das Feld Partition Offset ein. Um mit dem ersten Datensatz zu beginnen, geben Sie den Wert 0 ein.

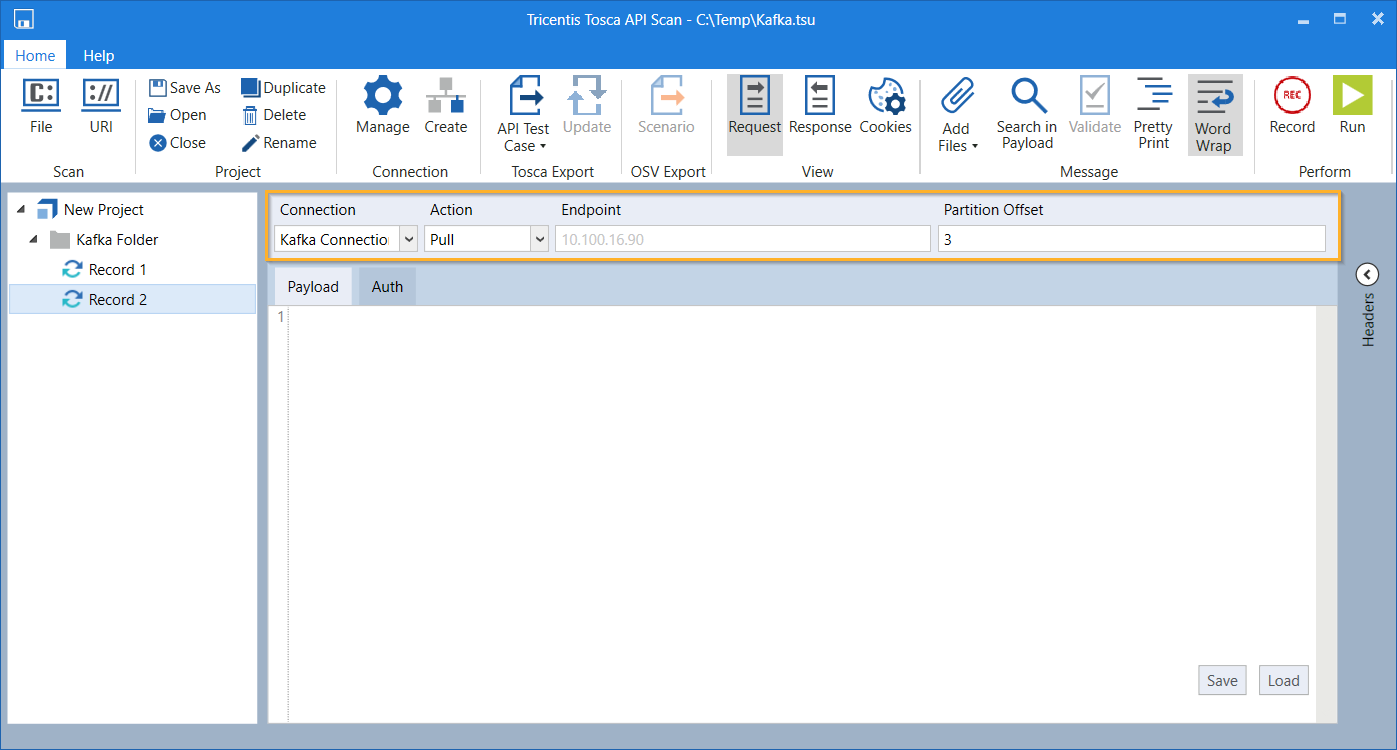

Connection, Action und Partition Offset konfigurieren

-

Klicken Sie im Menü API Scan auf

Run, um einen Datensatz per Pull aus dem Thema abzurufen.

Run, um einen Datensatz per Pull aus dem Thema abzurufen.

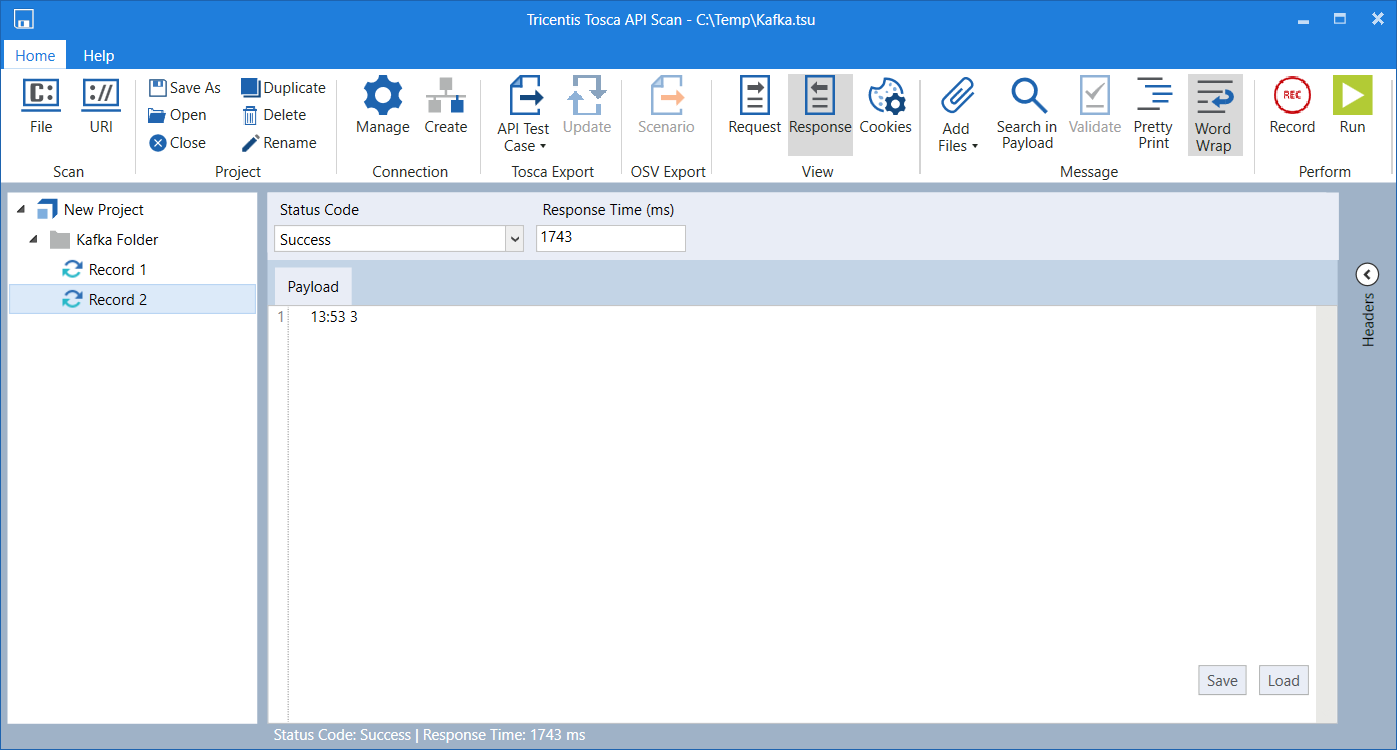

Response einer Pull-Nachricht

Datensätze per Push verschieben

Um Datensätze per Push in ein Kafka-Thema zu verschieben, führen Sie die folgenden Schritte aus:

-

Erstellen Sie eine Nachricht aus einem URI oder einer Datei oder erstellen Sie eine neue Nachricht.

-

Wählen Sie eine Kafka-Verbindung aus dem Aufklappmenü Connection.

-

Wählen Sie Push aus dem Aufklappmenü Action.

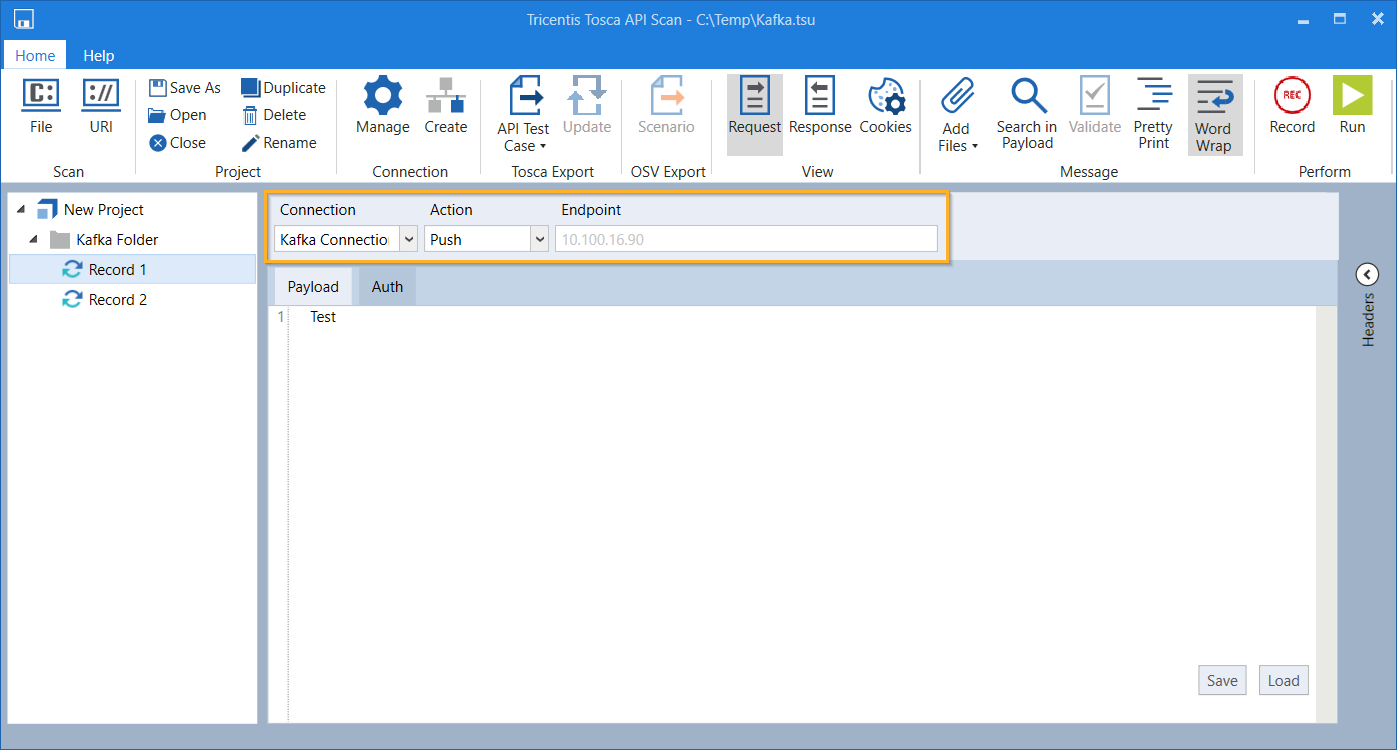

Connection und Action auswählen

-

Klicken Sie im Menü API Scan auf

Run, um Ihren Datensatz per Push in das Thema zu verschieben.

Run, um Ihren Datensatz per Push in das Thema zu verschieben.

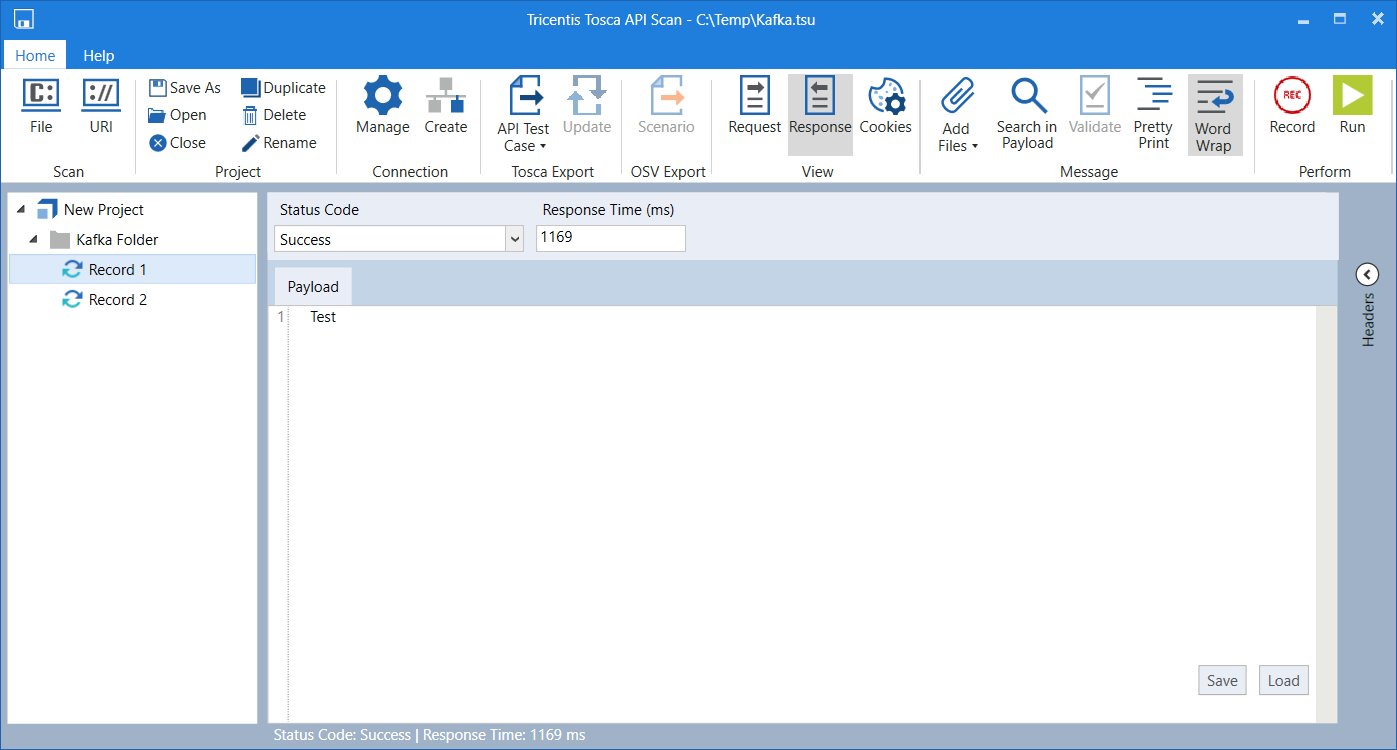

Die Response zeigt, ob der Datensatz erfolgreich per Push in das Thema verschoben wurde.

Response einer Push-Nachricht